在人工智能的快速发展中,大语言模型(LLM)带来了革命性的变革。近期,Google DeepMind的首席科学家Denny Zhou在斯坦福大学的CS25课程中,分享了他对LLM推理机制的重要见解。这一讲座为学习和研究LLM的人们提供了清晰且易懂的解读,揭示了大模型推理的核心原理和最新进展。

Denny Zhou提炼了LLM推理的四个关键点。LLM中的推理过程意味着生成一系列中间的token,尽管这种过程与人类推理的相似性不是重点,关键是Transformer模型通过生成众多中间token变得极其强大,从而不需要扩展模型的规模。这一观点挑战了传统对AI推理的认知,展示了LLM如何在有限的架构中实现令人印象深刻的推理能力。

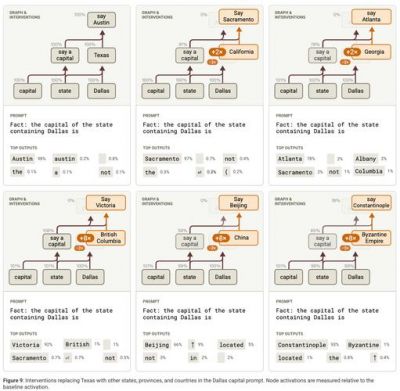

Denny强调,经过预训练的模型在未经过任何微调的情况下已经具备了推理能力。基于推理的输出往往不会出现在输出分布的顶部,因此,标准的贪婪解码方法无法有效呈现这些输出。这让我们认识到,推理的显现需要某种优化手段以引导模型更好地完成任务。

第三,提示技巧和监督微调的使用曾是触发LLM推理的主要方法,但现强化学习微调(RL Fine-Tuning)已经被证明是最强大的方法之一。根据Denny的描述,这一技术的提出归功于多个实验室的独立发现,而在谷歌,这一成果尤为突出,由Jonathan Lai带领的团队进行了深入研究。

,通过生成多个响应并将其聚合而非依赖单一响应的方法,能够显著提升LLM的推理能力。这一策略与我们对答案的理解密切相关,越多的不同回答被生成并相互比较,最终得出的结果往往更可信、更准确。

Denny Zhou的成就令人瞩目。他不仅在Google Brain创立并领导了推理团队,还在其后加入DeepMind,专注于开发具备推理能力的LLM,以推动人工智能的通用智能发展。Zhou的研究领域涵盖链式思考提示(chain-of-thought prompting)、自一致性(self-consistency)及LLM的优化等,他在学术界的影响力显著,累计超过83,000次引用。

在课程中,Zhou进一步探讨了推理的重要性,并与斯坦福大学的学者们合作提出了一则理论:任何能通过布尔电路解决的问题,均可以借由生成中间token的方式,通过固定大小的Transformer模型解决。这一理论既具有创新性,也为理论与实践提供了新的理解路径。

对于推理过程中的技术细节,Zhou发现模型的推理能力并不依赖于大量的提示,关键在于解码过程。这一发现颠覆了我们以往的认识,表明简单的自然语言提示可以有效引导模型自主进行推理。例如,在处理某个简单数学问题时,通过采用链式推理解码的方法,模型能够生成多个候选回答,最终选出置信度最高的答案,从而无须依赖贪婪解码。

提到微调的策略时,Denny指出,监督微调(SFT)的思路虽然简单有效,但在面对泛化能力的挑战时,模型的表现受到限制。为了解决这一问题,DeepMind团队提出了自我提升的概念,旨在通过模型自身生成训练数据而非依赖人工标注,从而实现数据的高效利用和模型的自我优化。

在强化学习微调方面,Denny介绍了他的团队在2024年取得的进展,强调了机器生成的数据在某些情况下优于人类构建的数据,这一发现引发了关于数据来源和生成方式的新讨论。随着技术的不断发展,深度学习团队的理念也逐渐趋向深度研究,重视通过检索和推理的结合来提升模型的解决问题能力。

Denny Zhou道,尽管LLM的推理能力依然在探索阶段,但利用多种方法优化推理过程的策略已经展现出了卓越的效果。随着研究的深入,未来的突破不再集中在单一的基准测试上,而应当关注更复杂的应用场景。

Denny的演讲不仅为人工智能领域的研究人员提供了宝贵的见解,也激励了更多的人深入研究和探索LLM的潜力。因此,对于所有学习LLM的人理解推理机制的核心要素将是他们在这条不断发展的道路上不可或缺的一部分。