在当今的人工智能领域,强化学习(RL)成为了一个热门话题。随着技术的不断进步,众多新模型的推出也让我们重新审视AI发展的可能性。特别是中国AI公司DeepSeek的崛起,其在强化学习领域的创新不仅带来了新的技术突破,也为AI模型的自我提升开辟了新的方向。

深度学习的模型性能主要依赖于数据和计算资源。而近年来,随着诸如OpenAI、Meta以及Anthropic等科技巨头的不断探索,预训练和测试时间计算(TTC)逐渐被认为是提升模型效能的两大主要杠杆。这种依赖于大量数据的模型训练在2024年面临瓶颈,OpenAI的研究者们甚至预测“我们所知的预训练会终结。”基于RL的模型微调和自我优化机制迅速引起关注,凭借其能够在有限的人为干预下实现智能化提升,DeepSeek便成为了这个领域的先锋。

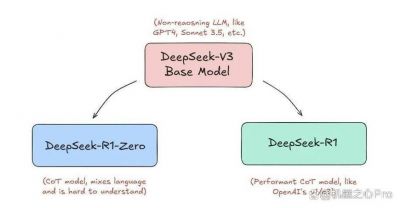

DeepSeek的核心创新在于其利用强化学习技术对大型语言模型(LLM)进行优化的全新方法。以其最新发布的"-Zero"模型为例,这一模型在没有任何人类数据干预的情况下,通过自我对弈的方式,利用轻量级的RL技术完成训练。与以往依赖于高质量人类数据的监督微调(SFT)不同,DeepSeek通过反馈机制让模型自主生成推理轨迹,并在此基础上进行强化学习,使得模型在推理能力上得到了显著提升。

这一自我提升的过程可以归结为一个闭环:生成的推理路径被评估、优化,形成新的数据反馈,再次生成推理路径,循环往复。这种递归的优化方式有效地打破了对外部数据的依赖,推动了模型性能的持续提升。

在强化学习的微调设置中,相较于传统的近端策略优化(PPO),DeepSeek的相对策略优化(GRPO)显然展示了更高的效率。传统RL过程依赖复杂的人工评估机制,而GRPO通过简化奖励机制并去除了评判模型,大幅减少了计算和存储开销。这使得整个强化学习过程不仅更为轻便,也更加适合去中心化的框架搭建。

正如当前的技术趋势,去中心化正在重新塑造AI的发展方向。DeepSeek的成功案例为我们提供了一个新的视角:如何在分散的计算环境中实现高效的模型训练和优化。在这一过程中,需要建立去中心化的预训练网络,以确保模型基础构建的高效性。同时,去中心化的训练环境能够吸引来自不同领域的贡献者,他们可以将自己的推理样本和想法贡献到这个生态系统中,从而形成一个庞大的数据库供AI模型进行微调和优化。

为了更好地实现这一构想,未来的工作可以借鉴当前流行的开源,例如OpenAI Gym、CARLA等,这些为开发者提供了丰富的环境,帮助评估和优化机器学习算法。在去中心化的训练环境下,设计多样化的推理数据生成框架以及可靠的数据评估机制将是成功的关键。

这一过程的挑战不容忽视。模型的预训练依然是整个体系中的高难度环节,需要巨大的计算资源与数据支持。如何设计一种有效的框架以确保不同参与者可以协同工作、共享资源,也是一大挑战。

但DeepSeek通过其革命性的RL微调方法展现了在AI模型自我提升方面的巨大潜力。未来,若能成功实现去中心化及分布式的训练环境,AI模型将能够在更广泛的领域中发挥卓越表现,推动整个行业的进步。

DeepSeek所展现的RL新方法不仅点燃了人们对AI未来的憧憬,更为整个AI领域的发展指明了方向。随着技术的不断发展,我们期待看到更加强大的AI模型如何在自我学习与优化的进程中,引领智能科技的崭新篇章。